酷澎如何開發和應用生成式AI

酷澎如何開發和應用生成式AI酷澎內部常用的三大類LLM應用,包括了圖像與語言理解、大規模弱標籤生成,以及分類與屬性提取。

第一類圖像與語言理解。酷澎從實驗得知,利用多模態LLM同時根據圖像和文字數據,來生成嵌入向量,準確度高於單獨用用圖片向量或是單獨用文字向量的檢索

用LLM,生成大量文本內容的標註。酷澎經實驗發現,這些標註用於弱監督式訓練時,效果可媲美人工標註資料

為產品分類和提取屬性時,酷澎舊有做法是為每個商品類別部署一個單獨的ML模型

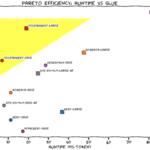

酷澎主要選用中文、韓文及日文語言表現比較強的開源模型,包括Qwen、Llama 3、Orion、Polyglot、Orion、T5、BERT等,並根據不同應用場景,選擇不同參數規模版本。

翻譯、標註生成、RAG用途的模型,選擇100億個參數以上版本;實體抽取(Entity extraction)及關鍵字生成,使用10億到100億個參數版本;生成嵌入向量等用途,則使用10億以下版本。

翻譯、標註生成、RAG用途的模型,選擇100億個參數以上版本;實體抽取(Entity extraction)及關鍵字生成,使用10億到100億個參數版本;生成嵌入向量等用途,則使用10億以下版本。

AI趨勢周報第265期:BERT的接班模型來了

AI趨勢周報第265期:BERT的接班模型來了ModernBERT,是一款只有編碼器的Transformer架構模型

第一款用大量程式碼訓練的編碼器。這些特點,讓ModernBERT擅長原本開源模型難以處理的領域,像是大規模的程式碼搜尋、新IDE功能,又或是因為能處理更長序列,能實現基於全文件檢索的RAG(因為以前模型能處理的上下文序列小、導致語義理解不佳,RAG效果並不好)

Finally, a Replacement for BERT: Introducing ModernB...

Finally, a Replacement for BERT: Introducing ModernB...

Meta BLT語言模型架構突破分詞技術極限

Byte Latent Transformer: Patches Scale Better Than T...

BLT(Byte Latent Transformer)架構

BLT架構直接從原始位元組資料中學習,不再仰賴分詞單元。

BLT透過動態分組機制,能根據預測下一步的資料複雜度,將位元組分為大小不一的補釘(Patch),低複雜度的位元組可合併為較長的補釘,高複雜度資料補釘則會更細緻分割,讓模型專注處理資訊密集部分。

Meta更表示,BLT模型在處理輸入雜訊時,比分詞模型更強健,還更能理解語言學上的細微特徵,如字形結構和拼音規則等

Byte Latent Transformer: Patches Scale Better Than T...

BLT(Byte Latent Transformer)架構

BLT架構直接從原始位元組資料中學習,不再仰賴分詞單元。

BLT透過動態分組機制,能根據預測下一步的資料複雜度,將位元組分為大小不一的補釘(Patch),低複雜度的位元組可合併為較長的補釘,高複雜度資料補釘則會更細緻分割,讓模型專注處理資訊密集部分。

Meta更表示,BLT模型在處理輸入雜訊時,比分詞模型更強健,還更能理解語言學上的細微特徵,如字形結構和拼音規則等